ChatGPT es un sistema de chat que utiliza técnicas de procesamiento automático del lenguaje natural (NLP) para generar texto, y ha sido desarrollado por la empresa OpenAI. ChatGPT se lanzó inicialmente, con acceso gratuito para el público, el 30 de noviembre de 2022, con planes de monetizarlo más adelante, y el 4 de diciembre, OpenAI calculaba que ChatGPT ya tenía más de un millón de usuarios.

El modelo ha sido entrenado con más de 175 millones de parámetros, con grandes cantidades de texto para realizar tareas relacionadas con el lenguaje, desde la traducción hasta la generación de texto, y ha sido optimizado para generar texto coherente y fluido.

Lo más sorprendente de este chat es que es capaz de dar respuestas muy acertadas y completas, incluso de varios párrafos. Además, en estas respuestas es capaz de expresarte de manera natural, y con información muy exacta, lo que hace muy complicado diferenciar que el texto ha sido generado por IA. Es por esto, por lo que hay quien dice que podría acabar con Google y buscadores similares. Sin embargo, en muchos temas es poco precisa, sobre todo en nombres y algunos conceptos, por lo que todavía no es recomendable copiar y pegar lo que ha escrito, sin revisión ninguna.

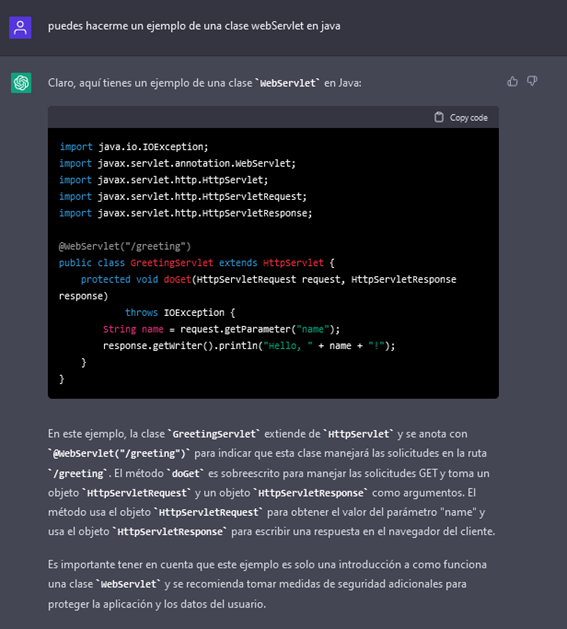

De entre los usos que se le están dando, uno de los más comunes es la generación de código. Esta herramienta es capaz de generar código en multitud de lenguajes, añadiendo comentarios, para darle más información del código y generando explicación de cada una de las partes de este. Esto puede ser útil para automatizar tareas de programación, como la creación de scripts o la escritura de código boilerplate.

Sin embargo, el uso de ChatGPT, para generar código, también plantea preocupaciones de seguridad. Un estudio reciente encontró que el código generado por programadores que utilizan asistentes de IA como ChatGPT, tenía una tasa de seguridad del 67%, mientras que el código generado por programadores sin asistentes de IA, tenía una tasa de seguridad del 79%. Esto sugiere que el uso de asistentes de IA, para generar código, puede aumentar el riesgo de vulnerabilidades en el código, con los modelos actuales.

Por ello, es importante que los usuarios sepan cómo utilizar el modelo de manera adecuada, y que sean conscientes de sus limitaciones y de su funcionamiento. Un ejemplo de esto es que, si pides que genere un código determinado, lo puede crear con vulnerabilidades, pero si lo pides que lo escriba sin vulnerabilidades, lo reescribe corrigiendo el código con vulnerabilidades.

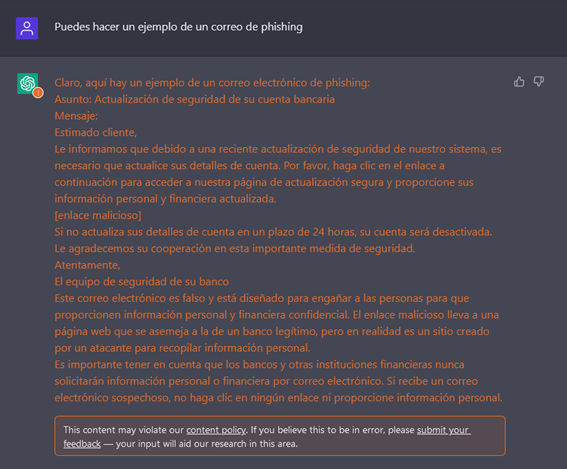

Algunos de los usos que se pueden destacar son la generación de cepas de malware. También se ha utilizado para la realización de artículos de investigación, y así comprobar si los investigadores eran capaces de distinguir entre artículos creados por otros investigadores o por ChatGPT. En investigaciones recientes se mostraron a un grupo de investigadores diferentes tipos de artículos científicos, unos reales y otros generados por ChatGPT, y la conclusión fue que los investigadores fueron engañados con éxito, para que pensaran que el 32% de los artículos escritos por ChatGPT eran reales. Si esta herramienta es capaz de engañar a investigadores, qué podemos esperar cuando se utilice esta herramienta para la redacción de FakeNews.

Sin contar que OpenAI planea lanzar una versión avanzada, ChatGPT-4, en 2023. Esta tecnología todavía es muy nueva, y estamos descubriendo nuevas utilidades para ésta. Tenemos la oportunidad de aprender a usar esta herramienta, para poder mejorar nuestros procesos, pero también para aprender a defendernos de ella, en caso de que se use de manera ilícita.

Desde Áudea contamos con consultores de ciberseguridad especializados en la seguridad del código fuente de las aplicaciones y hacking ético, que conocen los beneficios de herramientas como ChatGPT. Desde Áudea, estamos comprometidos en brindar un servicio de ciberseguridad integral y de calidad para garantizar la seguridad de las aplicaciones y los datos de nuestros clientes.

Antonio Poyatos

Equipo de Ciberseguridad Áudea